논문 원본: https://arxiv.org/abs/1512.00567

Rethinking the Inception Architecture for Computer Vision

Convolutional networks are at the core of most state-of-the-art computer vision solutions for a wide variety of tasks. Since 2014 very deep convolutional networks started to become mainstream, yielding substantial gains in various benchmarks. Although incr

arxiv.org

논문 간단 요약: 기존 모델의 문제점을 보완한 Incpetion-v2 와 Inception-v3를 제안

Inception 아키텍처의 주요 아이디어는 컴퓨터 비전 컨볼루션 네트워크에서 국부적으로 희소한 구조를 대략적으로 설계하는 것

Inception V1, V2, V3 비교표

| 항목 | Inception V1 (GoogLeNet, 2014) | Inception V2 (2015) | Inception V3 (2015) |

| 주요 개선점 | - Inception 모듈 도입 - 1×1 컨볼루션을 활용한 연산량 감소 - Auxiliary Classifier (보조 분류기) 사용 | - Batch Normalization (BN) 추가 - Factorized Convolution (5×5 → 3×3 두 개) - Grid Size Reduction (풀링과 스트라이드 2 조합) | - Factorized 7×7 Convolution - Label Smoothing - RMSProp Optimizer 도입 - Auxiliary Classifier 개선 |

| Inception 모듈 특징 | - 1×1, 3×3, 5×5, Max Pooling을 병렬 적용 | - 5×5 컨볼루션을 3×3 두 개로 분할하여 연산량 최적화 | - 7×7 컨볼루션을 (1×7) + (7×1)로 분할하여 연산량 최적화 |

| 연산 최적화 | - 1×1 컨볼루션으로 차원 축소 | - 5×5 연산을 줄이기 위해 3×3 두 개로 대체 | - 7×7 연산을 줄이기 위해 1×7 + 7×1로 분할 |

| 활성화 함수 | ReLU | ReLU + Batch Normalization | ReLU + Batch Normalization |

| 보조 분류기 (Auxiliary Classifier) | O (기울기 소실 방지) | O (이전보다 개선됨) | O (성능 향상됨) |

| 풀링 레이어 적용 | 전통적인 방식 (Max Pooling) | Grid Size Reduction 도입 | Grid Size Reduction 도입 |

| 정규화 기법 | 없음 | Batch Normalization | Batch Normalization + Label Smoothing |

| 최적화 기법 | SGD (Stochastic Gradient Descent) | SGD + Batch Normalization | RMSProp Optimizer 사용 |

| 연산량 | 비교적 많음 | 연산량 최적화 (5×5 → 3×3) | 더욱 최적화 (7×7 → 1×7 + 7×1) |

| 성능 개선 | 기존 CNN 대비 우수 | Inception V1보다 학습 안정성 증가 | Inception V2보다 더 나은 정규화 및 최적화 |

요약

- Inception V1은 기본적인 Inception 모듈을 도입하여 다양한 커널 크기를 병렬로 적용하는 구조

- Inception V2는 Batch Normalization과 Factorized Convolution을 활용하여 연산량을 줄이고 학습 안정성을 높임

- Inception V3는 7×7 Factorized Convolution, Label Smoothing, RMSProp Optimizer 등의 기술을 추가하여 더욱 성능을 향상

Abstract

- 컨볼루션 신경망(Convolutional Networks, CNN)은 최신 컴퓨터 비전 기술의 핵심임.

- 2014년 이후 CNN이 대중화되면서 다양한 벤치마크에서 성능이 급격히 향상됨.

- 그러나 모델 크기 증가 및 연산량 증가가 즉각적인 성능 향상으로 이어지지는 않음.

- 모바일 비전 및 빅데이터 처리와 같은 응용에서는 연산 효율성과 적은 매개변수 수가 중요함.

- 본 논문에서는 연산량을 효과적으로 활용하면서도 성능을 극대화하는 방법을 연구함.

- 적절한 합성곱 분해(Factorized Convolutions) 및 강력한 정규화 기법(Aggressive Regularization)을 활용하여 CNN을 확장하는 전략을 제안함.

- ILSVRC 2012 이미지 분류 실험에서 제안된 방법이 기존 모델 대비 상당한 성능 향상을 보임:

- Top-1 Error: 21.2% → 17.3%

- Top-5 Error: 5.6% → 3.5%

- 단일 모델(single model) 기준으로, 제안된 네트워크는 5억 개의 곱셈-덧셈 연산량 및 15M 매개변수를 사용하여 높은 성능을 달성함.

1. Introduction

- AlexNet (2012 ImageNet 챔피언 모델) 이후 CNN이 다양한 컴퓨터 비전 작업에 적용됨.

- 객체 탐지(Object Detection)

- 분할(Segmentation)

- 인간 포즈 추정(Human Pose Estimation)

- 비디오 분류(Video Classification)

- 객체 추적(Object Tracking)

- 초해상도(Superresolution)

- 2014년 이후 CNN 아키텍처는 더 깊고 더 넓은 네트워크를 활용하여 성능 향상을 달성함.

- VGGNet (2014): 단순한 구조지만 매우 깊은 네트워크를 활용하여 성능을 높임.

- GoogLeNet (2014): 제한된 연산 자원 내에서 성능을 극대화하도록 설계됨.

- AlexNet 대비 매개변수 수 12배 감소(60M → 5M)

- VGGNet 대비 3배 적은 연산량으로도 높은 성능

- GoogLeNet의 연산량은 VGGNet보다 훨씬 적지만,

Inception 네트워크가 더욱 발전하면서 빅데이터 처리에도 적용 가능해짐. - 다만, Inception 구조는 복잡하여 확장 및 구조 수정이 어렵다는 단점이 있음.

- 따라서, 본 논문에서는 효율적인 네트워크 확장을 위한 원칙과 최적화 전략을 탐색함.

2. General Design Principles

- CNN 아키텍처를 효율적으로 확장하기 위해 5가지 설계 원칙(Design Principles)을 제안함.

- 이러한 원칙들은 Inception 아키텍처에만 국한되지 않으며, CNN 확장 전반에 적용 가능함.

1️⃣ 표현 병목(Representational Bottleneck) 회피

- 피드포워드 네트워크는 정보 흐름이 입력 → 중간 계층 → 출력 순서로 진행됨.

- 네트워크에서 출력과 입력을 분리할 때 병목이 발생하면 성능 저하가 발생함.

- 따라서 초기 네트워크에서는 극단적인 차원 축소를 피하는 것이 중요함.

- 표현 차원의 감소는 천천히 진행해야 함.

2️⃣ 높은 차원의 표현(High-Dimensional Representations) 활용

- 네트워크 내부에서 활성화 채널 수(activations per tile)를 증가시키면 표현력이 향상됨.

- 더 분리된(disentangled) 특징 표현이 가능해져 학습 속도가 증가함.

3️⃣ 공간적 집계(Spatial Aggregation) 최적화

- 높은 차원의 특징을 사용하면 공간적 집계를 저차원에서 수행해도 성능 저하가 없음.

- 예를 들어, 3x 합성곱 전에 차원을 줄이면 연산량을 줄이면서도 표현력을 유지할 수 있음.

- 이는 인접 유닛 간 강한 상관관계(strong correlation)를 활용하기 때문임.

- 이러한 차원 축소는 학습 속도를 빠르게 하는 데도 기여함.

4️⃣ 네트워크의 너비와 깊이 균형 유지(Balance Width and Depth)

- 필터 수(stage-wise filter count)와 깊이(depth)를 적절히 조절하는 것이 중요함.

- 단순히 깊이만 증가시키는 것이 아니라,

연산량을 균형 있게 배분해야 최적의 성능을 달성할 수 있음. - 연산량이 일정한 경우, 병렬화(parallelization)를 통해 최적의 성능을 낼 수 있음.

5️⃣ 효율적인 연산 최적화(Computational Efficiency)

- 네트워크 구조를 단순히 확장하는 것이 아니라,효율적인 연산을 통해 성능 향상을 도모해야 함.

3. Factorizing Convolutions with Large Filter Size

- GoogLeNet(2014)의 주요 성능 향상 요소는 차원 축소(Dimensionality Reduction) 임.

- 이는 큰 합성곱을 작은 합성곱으로 분해하여 연산량을 절감하는 방식과 유사함.

1x1 → 3x3 합성곱으로의 분해

- 예를 들어,

- 1×1합성곱 → 3×3합성곱으로 진행하면,

- 근접한 활성화(activations of nearby neurons)가 강하게 상관되어 있음을 활용할 수 있음.

- 즉, 먼저 정보를 압축한 후, 공간적으로 확장하는 방식이 가능함.

- 이 방식은 정보 손실 없이 연산량을 줄이면서도 표현력을 유지할 수 있음.

3.1 Factorization into Smaller Convolutions

더 큰 공간 필터(예: n×nn \times n 또는 m×mm \times m)가 있는 컨볼루션은 계산 측면에서 2차적으로 증가한다(n×nn \times n 필터가 있는 컨볼루션은 m×mm \times m 필터가 있는 그리드에 있음). 계산량은 동일한 필터 수의 1×11 \times 1 convolution보다 n2n^2 배 더 많다. 동시에 더 큰 공간 필터는 추가 단위 활성화와 신호(더 넓은 시야) 간의 종속성을 캡처할 수 있으므로 필터의 기하학적 크기가 직접 감소하면 표현력이 손실된다.

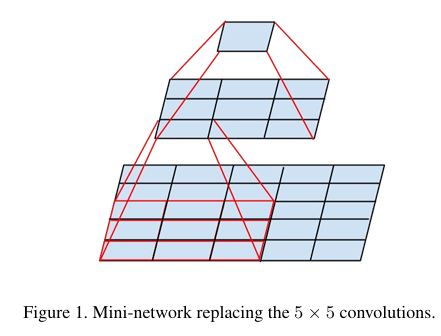

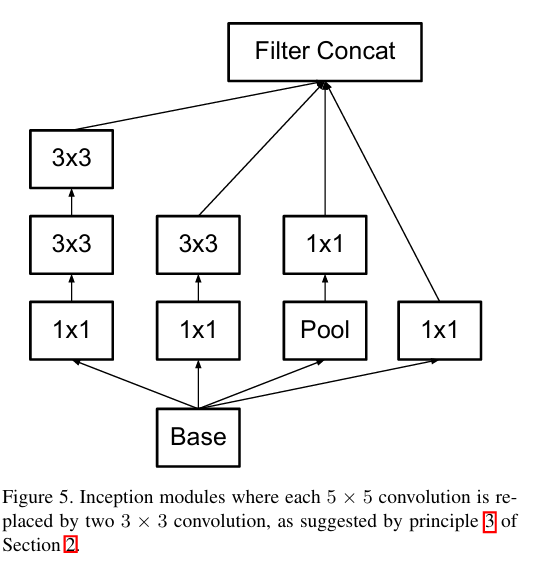

계산과 시야의 두 가지 요소의 균형을 맞추는 방법은 작은 컨볼루션 커널을 계단식으로 연결하여 큰 컨볼루션 커널을 교체하는 것이다. 예를 들어 2계층 3×33 \times 3 convolution을 사용하면 아래 그림과 같이 5×55 \times 5 convolution과 같은 field of view를 얻을 수 있지만 계산량은 두 배로 증가할 뿐 더 이상 제곱이 증가하지 않는다(5×55 \times 5를 직접 사용하는 것보다 28%의 상대적 이득이 발생함). 동시에 네트워크의 비선형성을 깊게 만든다.

5×5 컨볼루션을 2개의 3×3 컨볼루션 연산으로 인수분해하여 계산 속도를 향상시킨다. 이것이 직관적이지 않게 보일 수 있지만 5×5 컨볼루션은 3×3 컨볼루션보다 2.78배 더 비싸다. 따라서 실제로 두 개의 3×3 합성 곱을 쌓으면 성능이 향상된다.

- 큰 필터 크기(예: 5×5, 7×7)는 연산량이 기하급수적으로 증가함.

- 예를 들어,

- 5×5합성곱은 3×3합성곱보다 2.78배 많은 연산량이 필요함.

- 따라서, 큰 필터를 작은 필터로 분해하여 연산량을 줄이는 것이 효율적임.

🔹 5×5 → 두 개의 3×3 합성곱으로 분해

- 단순히 5×5 합성곱을 하나 적용하는 대신,

- 두 개의 3×3 합성곱을 연속적으로 적용하면 연산량이 줄어듦.

- 이 방식은 가중치를 공유하여 모델의 매개변수를 줄이고 일반화 성능을 향상시킴.

- Figure 1에서 보듯이, 작은 네트워크를 사용하여 5× 합성곱을 대체하는 개념임.

🔹 필터를 더 작은 네트워크로 대체하는 개념

- Figure 3에서 기존 3×3 합성곱을 작은 네트워크로 변환하는 과정을 보여줌.

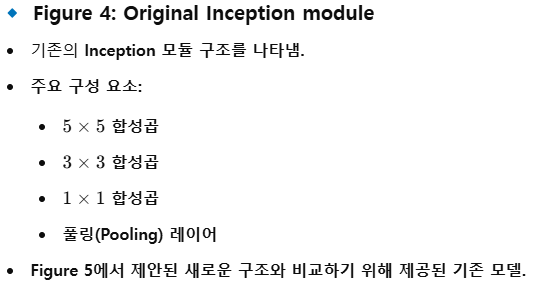

- Figure 4는 기존 Inception 모듈에서의 원래 설계를 나타냄.

- 이 접근법은 연산량을 줄이고, 네트워크가 더 깊은 표현을 학습할 수 있도록 함.

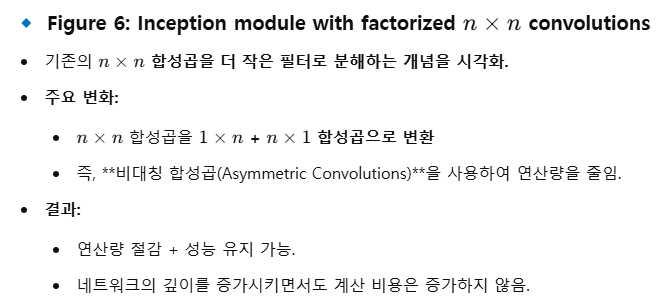

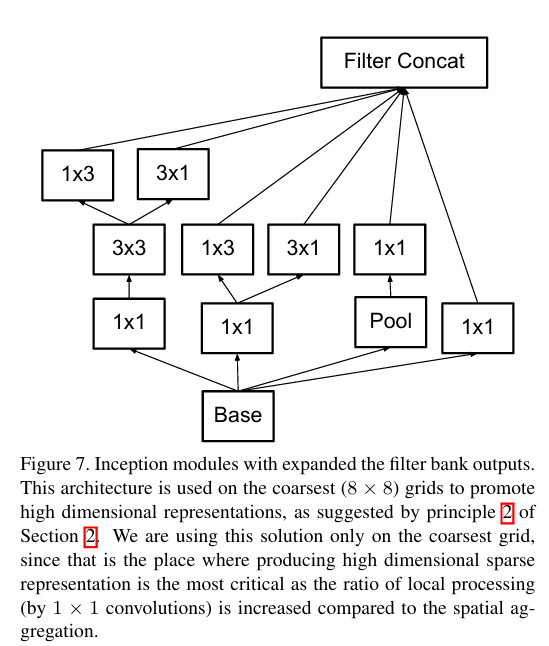

3.2 Spatial Factorization into Asymmetric Convolutions

- 이상의 큰 필터는 추가적인 최적화가 가능함.

- 비대칭 합성곱(Asymmetric Convolutions)을 사용하면 연산량을 더욱 줄일 수 있음.

🔹 n× 필터를 1 필터로 변환

- 예를 들어, 3×3필터를 3×1 + 1×3필터로 대체 가능함.

- 이는 연산량을 줄이면서도 동일한 수용 영역(Receptive Field)을 유지할 수 있도록 함.

- Figure 6에서 볼 수 있듯이, n×n 합성곱을 작은 필터로 분해하여 연산량 절감이 가능함.

🔹 5×5합성곱을 3×3 및 필터로 대체

- Figure 5와 Figure 7에서 Inception 모듈의 변형된 버전을 보여줌.

- 네트워크의 가장 큰 격자(grid)에서는 고차원 표현(high-dimensional representation)이 필요하므로,

- 1× 합성곱을 활용하여 채널 수를 증가시킴.

- 이렇게 하면 모델이 보다 복잡한 패턴을 학습할 수 있음.

4. Utility of Auxiliary Classifiers

- 보조 분류기(Auxiliary Classifiers)는 깊은 네트워크의 수렴 속도를 향상시킬 수 있음.

- 기존 연구에서는 보조 분류기가 학습을 보조하는 역할을 한다고 가정했음.

- 하지만, 본 논문에서는 보조 분류기가 단순한 정규화 역할을 수행한다고 주장함.

🔹 보조 분류기의 역할 재해석

- 이전 연구에서는 보조 분류기가 그래디언트 흐름을 돕는다고 가정했으나, 실험 결과 정규화 효과가 더 중요함.

- Figure 7에서 보듯이, 보조 분류기가 추가되면 네트워크가 학습하는 방식이 달라짐.

- 특히, 네트워크의 초기 학습 단계에서 보조 분류기가 안정적인 학습을 유도함.

- 결과적으로, 보조 분류기는 학습 속도를 빠르게 하고 모델의 일반화 성능을 향상시킴.

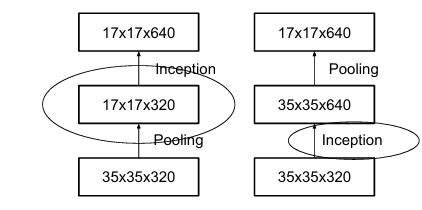

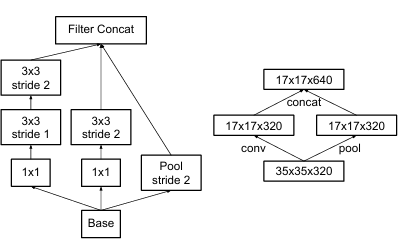

5. Efficient Grid Size Reduction

- CNN에서는 특징 맵(feature map)의 크기를 줄이기 위해 합성곱(convolution) 또는 풀링(pooling)을 사용함.

- 그러나, 풀링을 사용하여 크기를 줄이면 표현력(representational power)이 손실될 수 있음.

- 대안적인 방법:

- 기존 방식에서는 격자를 로 줄이려면, stride 2의 합성곱을 적용하고 풀링을 추가함.

- 하지만, 이는 네트워크의 표현력을 감소시킬 가능성이 있음.

🔹 개선된 방법 제안

원래 시작 블록에는 기능 맵의 크기를 줄이는 기능이 없다. 기능 맵을 줄이려면 블록과 풀링 레이어를 구현해야 한다. d×d×k의 기능 맵이 있다고 가정하고 d/2×d/2×2k의 크기로 변환하기 위해 먼저 1×1 컨볼루션을 사용하여 d×d×2k 가 될 수 있다. 그런 다음 풀링을 수행하면 금액이 매우 크다(아래 그림의 오른쪽 절반도 v1에서 사용한 방법임). 그러나 먼저 풀링한 다음 채널을 추가하면 병목 현상을 특성화하는 문제가 발생다(아래 그림의 왼쪽 절반).

- Figure 9

- 두 가지 방식의 격자 크기 축소(grid size reduction) 방법을 비교함.

- 왼쪽 방식: 기존 방법으로 축소 → 정보 손실 발생 가능.

- 오른쪽 방식: 3개 합성곱을 사용하여 점진적으로 크기를 줄임 → 표현력 유지 가능.

- Figure 10

- 풀링 대신 stride 2의 합성곱을 활용하는 방식을 시각적으로 설명함.

- 이렇게 하면 연산량을 줄이면서도 정보 손실을 최소화할 수 있음.

계산량을 줄이고 특징 표현을 유지하기 위해 저자는 두 단계 길이가 2인 convolution 부분과 pooling 부분을 사용하여 두 줄 구조를 제안한 것이다.

6. Inception-v2

- 기존 Inception 구조를 개선하여 새로운 Inception-v2 아키텍처를 제안함.

- ILSVRC 2012 이미지 분류 벤치마크에서 성능을 향상시키는 것이 목표임.

- 기존 합성곱을 세 개의 합성곱으로 분해하여 연산량 감소 (Section 3.1 아이디어 활용).

🔹 네트워크 구조 개요

- 격자 단계:

- 3개의 전통적인 Inception 모듈 사용 (각 모듈은 288개의 필터 보유).

- Section 5에서 제안된 Grid Reduction 기법을 적용하여 크기로 축소.

- 격자 단계:

- Figure 5에 제시된 Inception 모듈을 5번 반복 적용.

- Grid Reduction 기법을 사용하여 크기의 격자로 축소 (Figure 10 참고).

- 격자 단계:

- Figure 6에서 보여준 Inception 모듈 2개를 적용.

- 각 타일마다 2048개의 필터를 사용하여 최종 특징 표현을 생성.

- 최종 출력 단계:

- 완전 연결 레이어(Fully Connected Layer) + Softmax를 사용하여 1000개 클래스 분류.

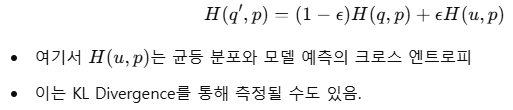

7. Model Regularization via Label Smoothing

- 본 섹션에서는 라벨 스무딩(Label Smoothing) 기법을 활용하여 모델의 분류 성능을 정규화(regularize)하는 방법을 제안함.

- 주요 목적:

- 모델이 특정 클래스에 대해 과도하게 확신(confidence)을 갖는 것을 방지

- 일반화 성능을 높이고, 과적합(overfitting)을 줄이기 위함

🔹 기존 크로스 엔트로피 손실의 문제점

- 모델은 일반적으로 크로스 엔트로피(Cross-Entropy) 손실을 최소화하여 학습됨:

여기서 q는 실제 레이블의 분포(Ground-Truth Distribution)

는 모델이 예측한 확률 분포(Predicted Distribution)

- 단일 정답(one-hot label) 사용의 문제:

- 기존 방식에서는 q(k)=1 (정답 클래스 k=y)이고, 나머지 클래스는 q(k)=0

- 이렇게 학습하면 모델이 특정 클래스에 대한 예측 확률을 1에 가깝게 만들도록 강제됨.

- 이로 인해 과적합(overfitting)이 발생할 가능성이 높아짐.

- 또한, 모델의 적응력(adaptability)이 감소하고, 새로운 데이터에서의 일반화 성능이 저하될 수 있음.

🔹 라벨 스무딩(Label Smoothing) 기법 제안

- 기존의 one-hot 레이블을 완전히 신뢰하는 것이 아니라, 조금 더 부드러운(soft) 분포로 변환함.

- 새로운 정규화된 레이블 분포 q′(k):

-

- 확률로 기존 원-핫 벡터를 유지하면서,

- ϵ 확률로 균등 분포로 레이블을 스무딩(조금씩 분산)하여 과적합 방지

🔹 LSR(Label Smoothing Regularization)의 효과

- 과도한 확신(confidence) 감소:

- 기존 방식에서는 특정 클래스의 확률이 1에 가깝도록 학습됨 → 일반화 성능 저하

- LSR을 사용하면 확률이 너무 극단적으로 쏠리는 것을 방지할 수 있음.

- 일반화 성능 향상:

- 모델이 예측을 좀 더 부드럽게 하여 새로운 데이터에서도 더 적절한 예측이 가능함.

- 수식적으로 크로스 엔트로피 손실을 다음과 같이 변형:

8. Training Methodology

- 네트워크 학습 방식:

- TensorFlow 분산 학습 시스템을 활용하여 학습 진행.

- 50개의 NVIDIA Kepler GPU를 사용하여 병렬 학습 수행.

- 배치 크기(Batch Size): 32

- 총 학습 Epochs: 100

- Optimizer 및 학습률 설정:

- Momentum Optimizer (β=0.9\beta = 0.9)를 사용한 초기 실험 이후,

- 최적의 성능을 보인 RMSProp 적용:

- Decay: 0.9

- Decay Factor: ϵ=10\epsilon = 10

- 학습률(Learning Rate): 0.045

- 학습률 감소 스케줄: 매 2 epoch마다 0.94배 감소

- 추가적인 학습 안정화 기법:

- Gradient Clipping (Threshold 20) 적용하여 그래디언트 폭발 문제 방지.

- 파라미터를 시간에 따라 Running Average로 계산하여 모델 평가 진행.

9. Performance on Lower Resolution Input

- 저해상도 입력을 사용하는 경우 모델 성능을 분석하는 실험 수행.

- 일반적인 객체 탐지(Object Detection)에서는

- 작은 이미지 패치(patch)를 분석하여 특정 객체를 분류하는 것이 핵심 과제임.

- 특히, 저해상도 객체(low-resolution objects)에 대한 모델 성능이 중요함.

🔹 저해상도 입력이 Recognition 성능에 미치는 영향 분석

- 일반적으로, 고해상도 입력을 사용하는 모델이 성능이 더 뛰어남.

- 그러나, 모델의 연산량(computational cost)을 일정하게 유지한 상태에서 해상도를 조절할 경우 성능 차이가 어느 정도 발생하는지 분석이 필요함.

- 주요 연구 질문:

- 해상도를 높이는 것이 항상 좋은가?

- 연산량을 동일하게 유지한 상태에서 해상도를 조절할 경우, 성능 차이가 얼마나 발생하는가?

🔹 실험 설정

- 세 가지 실험을 수행하여 해상도 변화에 따른 성능 차이 분석:

- 입력 해상도

- Stride 2 적용

- 첫 번째 레이어 이후 Max Pooling 수행

- 입력 해상도

- Stride 1 적용

- 첫 번째 레이어 이후 Max Pooling 수행

- 입력 해상도

- Stride 1 적용

- Max Pooling 없음

- 입력 해상도

🔹 실험 결과 분석

- 모든 네트워크의 연산량이 거의 동일하도록 조정 (단, 세 번째 네트워크가 약간 더 연산량이 적음).

- 모든 모델을 동일한 조건에서 학습한 후, ImageNet ILSVRC 2012 검증 세트에서 성능을 평가.

- 결과:

- 저해상도 입력을 사용한 모델도 최종 성능에서 큰 차이를 보이지 않음.

- 그러나, 학습 속도가 더 느려지는 경향이 나타남.

- 해상도를 줄이면 네트워크의 성능이 다소 감소하지만, 연산량 대비 성능 저하는 크지 않음.

🔹 추가적인 발견:

- 단순히 네트워크 크기를 해상도에 맞춰 줄이면 성능이 급격히 저하됨.

- 즉, 해상도를 줄인다고 해서 네트워크 크기를 비례적으로 줄이는 것은 부적절함.

- 연산량을 동일하게 유지하면서 해상도를 줄이면, 성능 저하를 최소화할 수 있음.

- Table 2의 실험 결과를 통해, 작은 객체 탐지(small object detection)에서는 낮은 해상도 전용 네트워크를 활용하는 것도 고려할 수 있음.

- R-CNN 같은 객체 탐지 모델에서, 저해상도 객체를 위한 별도의 네트워크를 설계하는 것이 효과적일 가능성이 있음.

10. Experimental Results and Comparisons

- Table 3 실험 결과:

- Inception-v2의 개선된 구조를 적용한 후, 단계별 성능 변화를 평가함.

- 각 Inception-v2 모델은 기존 구조에 새로운 변형을 추가하여 누적적인 개선 결과를 비교.

🔹 주요 실험 조건

- Label Smoothing 적용 여부 (Section 7 참고)

- 7 × 7 합성곱을 3 × 3 합성곱으로 분해하는 Factorization 기법 적용 여부

- 보조 분류기(Auxiliary Classifier)의 Fully Connected Layer에 Batch Normalization 적용 여부

🔹 평가 데이터셋

- ILSVRC 2012 검증 데이터셋 (Validation Set) 사용

- 총 50,000개 이미지 중, 평가에서 제외된 블랙리스트 이미지(Blacklisted Examples)를 제외한 48,238개 데이터로 평가

- 전체 데이터셋(50,000개) 기준으로도 성능 평가를 수행했으며,

- Top-5 Error는 약 0.1% 증가

- Top-1 Error는 약 0.2% 증가하는 결과를 보임.

- 최종적으로 Inception-v3 모델을 Multi-crop 및 Ensemble 평가 설정에서 성능 비교.

11. Conclusions

🔹 CNN 확장을 위한 주요 설계 원칙 제시

- 합성곱 신경망(Convolutional Neural Networks, CNN)을 확장하는 다양한 설계 원칙을 연구하고, 이를 Inception 아키텍처에 적용하여 성능을 평가.

- 이러한 원칙을 따를 경우, 연산량을 크게 증가시키지 않으면서도 높은 성능을 달성할 수 있음.

🔹 Inception-v3 성능 개선 요약

- ILSVRC 2012 분류 벤치마크에서 새로운 최고 성능(State-of-the-Art) 달성

- Single Crop 평가에서

- Top-1 Error: 21.2%

- Top-5 Error: 5.6%

- 기존 네트워크(Ioffe et al. [7]) 대비 연산량이 25%만 증가했지만 성능은 훨씬 향상됨.

- 기존 가장 성능이 좋았던 모델(He et al. [6])보다 Top-5 Error 25%, Top-1 Error 14% 감소.

- 기존 모델보다 6배 적은 연산량, 5배 적은 파라미터를 사용하면서도 더 뛰어난 성능 달성.

- Single Crop 평가에서

🔹 Inception-v3 Ensemble 성능

- 4개의 Inception-v3 모델을 앙상블(Ensemble)하여 평가한 결과:

- Multi-crop 평가에서 Top-5 Error: 3.5%

- 이는 기존 최고 성능 모델 대비 25% 이상의 성능 향상을 의미함.

- ILSVRC 2014에서 우승한 GoogLeNet 앙상블 대비 절반 수준의 오차율을 기록함.

🔹 저해상도 입력에서도 높은 성능 유지

- Receptive Field가 79 해상도인 경우에도 높은 성능을 유지

- 작은 객체(Small Object) 탐지 시스템에서도 효과적으로 적용 가능함을 시사.

🔹 Factorized Convolutions 및 Aggressive Dimension Reduction의 효과

- CNN 내부에서 합성곱을 적절히 분해(Factorization)하고, 적극적인 차원 축소(Dimension Reduction)를 수행하면

- 연산량을 절감하면서도 성능을 유지할 수 있음을 입증.

- 적은 파라미터 수와 추가적인 정규화(Regularization) 기법을 조합하면

- 비교적 적은 데이터셋에서도 높은 품질의 네트워크를 학습 가능.

참조

https://hyunsooworld.tistory.com/40

Inception v1,v2,v3,v4는 무엇이 다른가 (+ CNN의 역사)

- References https://youngq.tistory.com/40 https://junklee.tistory.com/111 https://medium.com/@msmapark2/vgg16-%EB%85%BC%EB%AC%B8-%EB%A6%AC%EB%B7%B0-very-deep-convolutional-networks-for-large-scale-image-recognition-6f748235242a https://velog.io/@whgurwns2

hyunsooworld.tistory.com

https://happy-support.tistory.com/66#google_vignette

[논문 리뷰 - Inception v2 & v3] Rethinking the Inception Architecture for Computer Vision (CVPR 2016)

본 논문은 CVPR 2016에 게재된 논문입니다. (저자 소속: Google)논문 링크: https://arxiv.org/pdf/1512.00567 1. Overview본 논문은 기존 모델의 문제점을 보완한 Incpetion-v2 와 Inception-v3를 제안합니다.Incpetion-v2 라

happy-support.tistory.com

'Paper review > CV' 카테고리의 다른 글

| You Only Look Once: Unified, Real-Time Object Detection (0) | 2025.05.02 |

|---|---|

| MobileNets: Efficient Convolutional Neural Networks (0) | 2025.04.04 |

| ELMo: Deep contextualized word representations (0) | 2025.03.28 |

| SPPNet: Spatial Pyramid Pooling in Deep (0) | 2025.03.28 |

| U-Net: Convolutional Networks for Biomedical Image Segmentation (0) | 2025.03.28 |